The Mondrian Process のメモ

The Mondrian Process

The Mondrian Process

Daniel Roy

2008年 Teh さんも共著の Mondrian Process の発表

視覚的にキャッチー(?)で興味を引く.

まだ,キラーアプリ(というかいいInference method ?)が無いようですが,

D. Roy 自身も,Teh さん自信も なんとなく端々から,けっこう「気に入っている」様子なのです.

僕も気になる存在ではあります.

簡潔にいうと DP の多次元拡張.

より,感覚的に言うと Stick Breaking Process の 多次元拡張です.

棒を折っていくのではなくて,面を切っていくというプロセスになります.

モチベーションとしては,

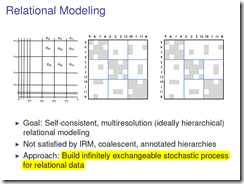

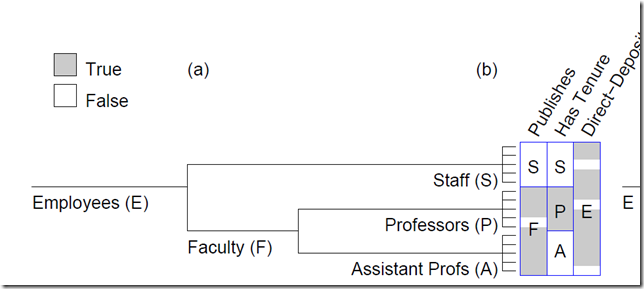

Royさんらが提案してきた Annotated Hierarchy とかは, Relational Data に対しての

Tree clustreing を bi-clustering できるようにしているのですが,

Self-consistent ではないということ.

Goal: Self-consistent, multiresolution (ideally hierarchical)relational modeling

ということです.

Not satisfied by IRM, coalescent, annotated hierarchies

といっているだけに,このモチベーションは IRM ,Annotated Hierarchies あたりを押さえていないと

よくわからない気がします.

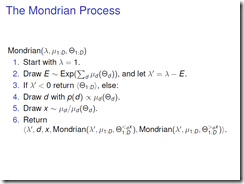

Mondrian Process の生成過程は木構造的なので再帰的にかけまして,

結局は縦方向と横方向に 予算 λが切れるまで分割し続けるというものです.

個人的には上の スライドの表記よりも 原著論文の 3.2 Generalizations tohigehr dimensions and trees の

方が簡単な例を示していて理解しやすいです.上の定義は 一般の測度まで自然に表現したもの.

↑3.2 に載っている簡単な例を 図解してみました. こちら.

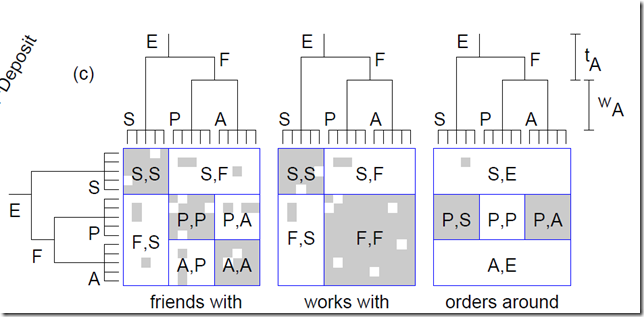

本論文では,これを使ってrelational data の co-cluastering に持って行きたい気持ちは

十分に語っているのですが,よいinference 手法を提案するまでは行っていないようです.

実験では

We employed a number

of Metropolis-Hastings (MH) proposals that rotated, scaled, flipped, and resampled portions of the

Mondrian.

ということで,とにかく いろんな提案分布を使って混ぜながら, MH法で inference したとのこと.

個人的な感想としては,スキなんですが,

ここまで自由度をもたせたco-clustering での結果を「どう解釈するか?」というのも,

難しい問題だなぁと思いました.

自由度的には IRMよりも AH よりも上がっているわけで,,,,,,

とはいえ,数学的にはイケテル構造物のようなのでどこかでブレイクスルーすることを期待しております.

ちなみに,個人的には,面っていっているけど,これって,やっぱり値付きの木構造の生成じゃないの?

と思ったりもします.なんとなくなので,詳細はより踏み込まないといけませんが.

やっぱり,IRMの使い勝手の良さが,今は先にたってるかな,,,という気もします.

集合を積集合で捉えるのって,非常にGeneral なので・・・

では,最後に必見の, Mondrian Process 動画をどうぞ・・・・

現状,僕はあまりいい応用法を思いつきませんが,フォローしたいと思います.

そして,これが,現代美術家 Mondrian の絵です.

Mondrian Process の 動画 > http://youtu.be/JLotRY0fIug

たにちゅー・谷口忠大・tanichu

たにちゅー・谷口忠大・tanichu

![ビブリオバトル[知的書評合戦]](img/bn_biblio.jpg)